2021. 1. 16. 16:47ㆍComputer vision 논문 & 코드리뷰

논문 링크: arxiv.org/abs/1812.10025

Attention Branch Network: Learning of Attention Mechanism for Visual Explanation

Visual explanation enables human to understand the decision making of Deep Convolutional Neural Network (CNN), but it is insufficient to contribute the performance improvement. In this paper, we focus on the attention map for visual explanation, which repr

arxiv.org

ABN은 attention map을 이용해 interpretable한 정보를 제공한다는 점에서 CAM과 유사하나, FC대신 GAP를 사용해 성능이 조금 떨어지는 CAM의 단점을 보완하여 interpretable한 정보 뿐만 아니라 성능향상의 효과까지 보여주었습니다.

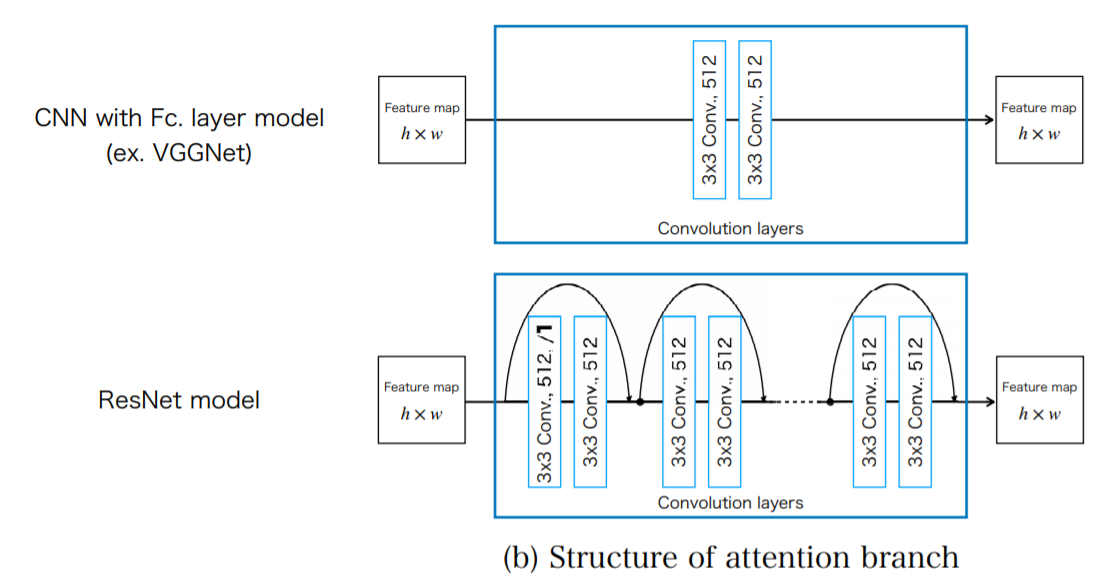

다음 그림에서 볼 수 있듯이, ABN은

1. feature extractor

2. Attention branch

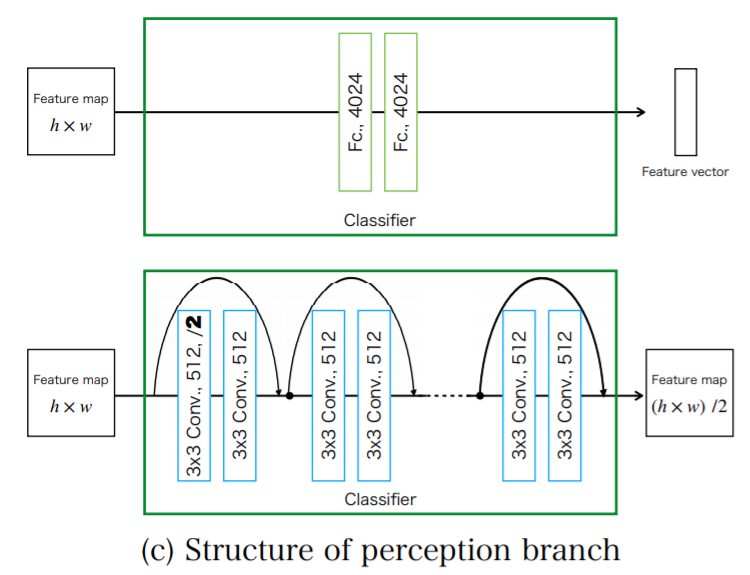

3. perception branch

로 이루어져 있습니다.

| feature extractor | feature map 생성 |

| Attention branch | attention map 생성 (CAM 참조) |

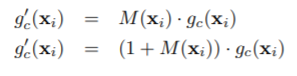

| perception branch |   위의 식으로 재구성한 featuremap을 기반으로 classification 결과를 도출합니다.(prob scores)  |

● Multi task learning(여러 object detection & classification)

ABN은 한 이미지에서 여러 object를 detection하는 방법도 제시합니다.

attention map을 detect하고 싶은 객체수 (T)만큼 만들어 여러개의 perception branch에 넣어주는 방법입니다.

-> t번째 attention map에 대한 재구성된 feature map과 probability scores

● Performance

CAM 이나 Grid CAM에 비해

한이미지에 여러 object 있을 때 훨씬 뛰어난 성능을 보여줍니다.

fine recognition에서도 좋은 성능을 보입니다.

차의 모델과 브랜드를 classification하는 test에서, 좋은 성능을 보였습니다.

'Computer vision 논문 & 코드리뷰' 카테고리의 다른 글

| Pix2Pix code review 코드리뷰 (0) | 2021.04.08 |

|---|---|

| [Pix2Pix]Image-to-Image Translation with Conditional Adversarial Networks (0) | 2021.03.30 |

| U-GAT-IT (0) | 2021.01.29 |

| Spatially Attentive Output Layer for Image Classification (SAOL)(CVPR 2020) (0) | 2021.01.16 |

| Class Activation Map(Learning Deep Features for Discriminative Localization) (CVPR2016) (0) | 2021.01.16 |